Im Jahr 1901 hat der italienische Mathematiker Mario Lazzarini das Buffonsche Nadelexperiment durchgeführt, um zu approximieren. Angeblich baute er dafür eine Maschine, um eine Nadel 3408 mal zu werfen und zu zählen, wie oft die Nadel so fällt, dass sie ein Gitter aus parallelen Linien kreuzt.

Die theoretischen Grundlagen des Experiments sind unumstritten, jedoch werden Lazzarinis Ergebnisse teilweise bezweifelt. Hauptkritik besteht in der Frage, ob die Anzahl der Versuche gerade so gewählt wurde, um die damalige Approximation möglichst gut zu treffen. Außerdem wird daran gezweifelt, ob die Nadelwurfmaschine tatsächlich existierte und die Nadelwürfe überhaupt stattgefunden haben.

Letztendlich ist es für uns egal, ob Lazzarini die Nadel (selber) geworfen hat oder nicht. Interessant ist an dieser Stelle dennoch, dass der komplette Versuchsaufbau darauf ausgelegt ist, lediglich eine Zahl zu ermitteln. Diese Zahl soll uns angeben, wie oft die Nadel das Liniengitter gekreuzt hat. Auf gewisse Weise fasst diese Zahl den relevanten Teil des Experimentes zusammen und lässt alle irrelevanten Informationen wie z.B. die genaue Nadelposition fallen. Damit diese Zusammenfassung eines Zufallsexperiments durch eine Variable auf einer fundierten mathematischen Basis steht, müssen wir dies sauber definieren.

Definition 3.1 (Zufallsvariable) Es sei ein Wahrscheinlichkeitsraum. Dann heißt die Abbildung Zufallsvariable, falls sie messbar bzgl. der Borel--Algebra ist, d.h. für alle .

Wie eben erwähnt ist eine Zufallsvariable also einfach eine Funktion, die ein Zufallsexperiment / Ereignis aus dem Grundraum nimmt und diesem Versuchsausgang eine reelle Zahl zuweist. Die einzige Bedingung, die wir zusätzlich stellen, ist die Existenz der Wahrscheinlichkeit für alle , d.h. egal welchen Wert die Zufallsvariable annimmt, die Wahrscheinlichkeit, dass dies passiert, ist wohldefiniert. Diese Wohldefiniertheit wird dadurch gesichert, dass die zugehörige Menge in der -Algebra enthalten ist.

Beispiel 3.1 Es sei ein Wahrscheinlichkeitsraum, wobei und

Definiere . Dann gilt und somit ist keine Zufallsvariable.

Definiere und bestimme die Urbilder für . Also ist eine Zufallsvariable.

In diesen Fällen war es einfach, alle relevanten Urbilder händisch zu bestimmen. Jedoch kann dies für komplizierte Zufallsvariablen anders sein. Praktischerweise gibt es ein Theorem, dass uns direkt die Messbarkeit einer Abbildung gibt, indem nur eine bestimme Klasse von Urbildern betrachtet wird.

Theorem 3.1 Es sei ein Wahrscheinlichkeitsraum und eine Abbildung auf dem Grundraum in die reelle Zahlen. ist eine Zufallsvariable genau dann, wenn für alle .

Üblicherweise interessiert es uns in der Stochastik gar nicht so sehr, wie die Abbildung in Abhängigkeit von definiert ist. Tatsächlich untersuchen wir hauptsächlich die Frage, welche Werte die Zufallsvariable annimmt und wie wahrscheinlich dies für konkrete Werte oder ganze Bereiche ist. Konkret begnügen wir uns damit “nur” die so genannte Verteilung von zu kennen.

Definition 3.2 (Verteilung) Es sei eine Zufallsvariable auf dem Wahrscheinlichkeitsraum . Die Funktion mit heißt Verteilung von .

Bemerkung 3.1 Zwar kommt die Größe in Definition 3.2 noch formal im Rahmen des Urbildes vor, allerdings werden wir schon bald sehen, dass für viele Klassen von Verteilungen, konkrete Wahrscheinlichkeiten in den Vordergrund und in den Hintergrund rücken.

Interessanterweise sind die in Theorem 3.1 betrachteten Mengen vollkommen ausreichend, um die Verteilung einer Zufallsvariable komplett zu charakterisieren. Dazu definieren wir uns die Hilfsfunktion

Definition 3.3 (Verteilungsfunktion) Es sei eine Zufallsvariable auf dem Wahrscheinlichkeitsraum . Die Verteilungsfunktion ist definiert als für alle .

und nun gilt

Theorem 3.2 Die Verteilung einer Zufallsvariablen wird eindeutig durch deren Verteilungsfunktion charakterisiert.

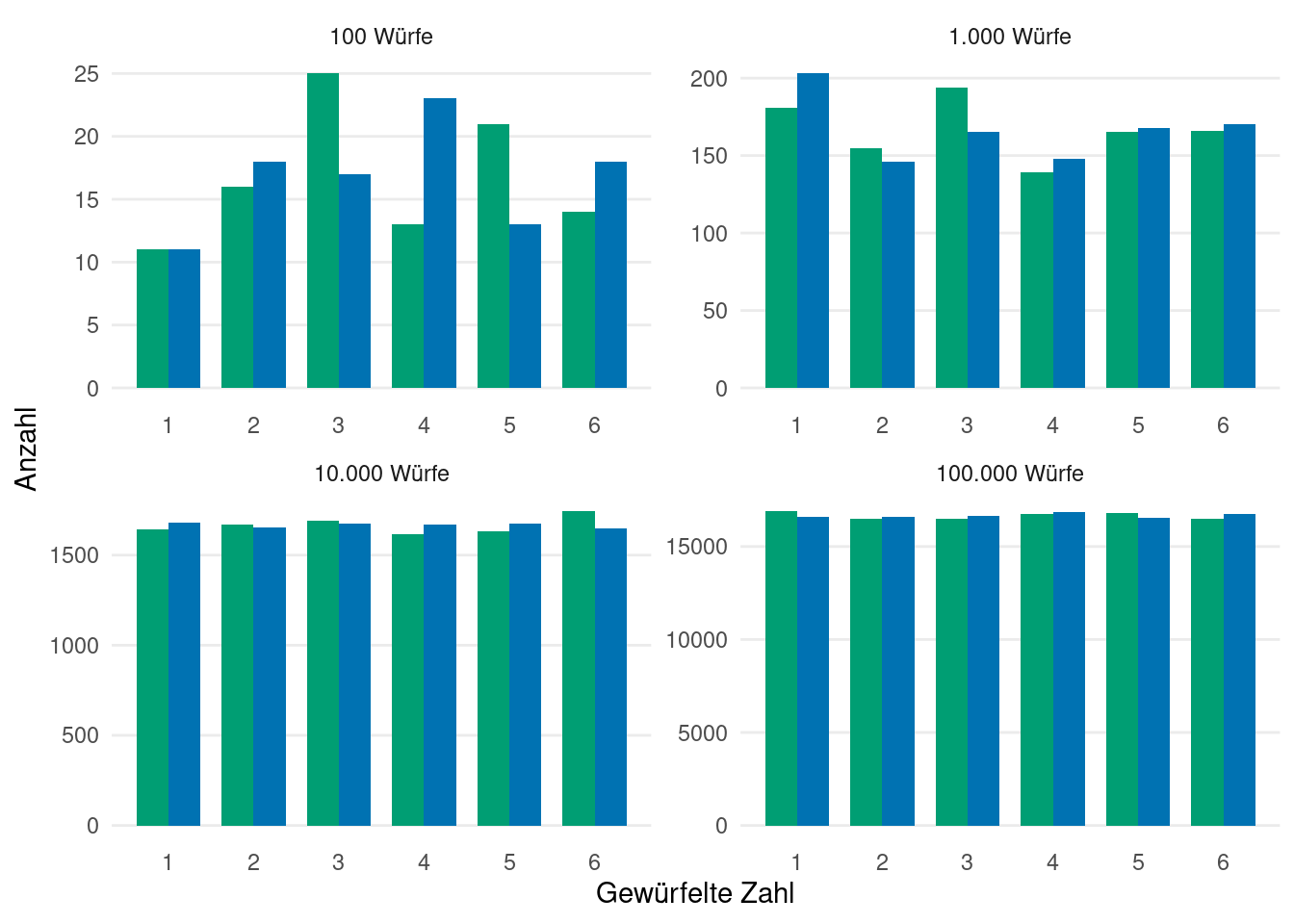

Beispiel 3.2 Nehmen wir an, dass wir einen blauen und einen grünen Würfel haben, die sich abgesehen von der Farbe um nichts unterscheiden. Nun sei die gewürfelte Augenzahl des grünen Würfels und die gewürfelte Augenzahl des blauen Würfels. Offensichtlich sind die Verteilungsfunktionen von und gleich und wir sprechen davon, dass und identisch verteilt sind.

Intuitiv bedeutet das allerdings nicht, dass und immer gleich sind. Schließlich würden wir ja nicht erwarten, dass der blaue und grüne Würfel immer die gleiche Zahl zeigen. Bildlich gesprochen bedeutet die identische Verteilung nur, dass die Histogramme der beiden Würfel sich annähern, je öfter gewürfelt wurde (siehe Abbildung 3.1).

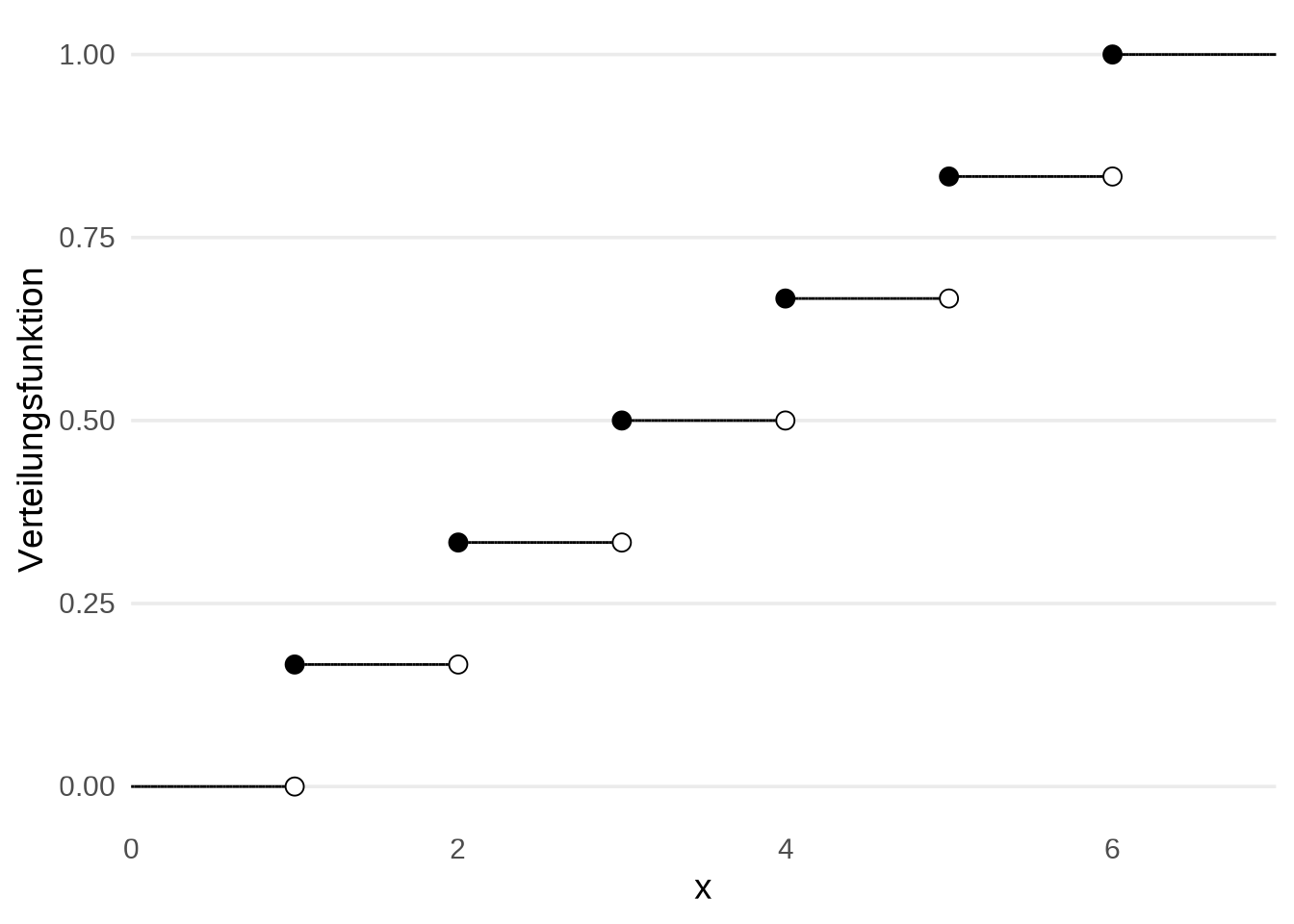

Weiterhin überlegt man sich schnell, dass für alle , für alle und für alle , da sinnvollerweise nur die Werte annehmen kann.

In dieser Aussage erkennen wir wieder, dass uns die wenig interessieren. Wir brauchen den Ausdruck nicht konkret definieren, um zu wissen, dass nach Möglichkeit für alle sein sollte, wenn tatsächlich die Augenzahlen des grünen Würfels beschreiben soll.

An dieser Stelle stoßen wir allerdings auf eine mathematische Spitzfindigkeit. Auch wenn uns die Rolle des nicht wirklich interessiert, so wollen wir die Funktion möglichst wenig einschränken. In diesem Fall können wir die Anforderungen an noch ein wenig aufweichen und stattdessen fordern, dass andere Werte annehmen darf, solange die Wahrscheinlichkeit, dass gleich 1 ist, also in Symbolen ausgedrückt . Wir sprechen hier davon, dass fast sicher in liegt.

Dies bestärkt nochmal die Tatsache, dass uns die gar nicht so sehr interessieren, da die Funktion auf einer Menge machen kann was sie will, solange . Dies ist am Anfang zunächst etwas gewöhnungsbedürftig, bietet aber im späteren Verlauf einige Vorteile.

Abschließend berechnen wir noch anhand des Beispiels und aus der Tatsache, dass für alle und sonst, dass für alle . Zusammenfassend haben wir also

Der Vollständigkeit halber noch ein Theorem bzgl. den Eigenschaften einer Verteilungsfunktion und der Existenz einer entsprechenden Zufallsvariable.

Theorem 3.3 Es gelten die folgenden zwei Aussagen.

Es sei eine beliebige Zufallsvariable. Dann besitzt deren Verteilungsfunktion die Eigenschaften

- Asymptotik: .

- Monotonie: für alle und .

- Rechtsseitige Stetigkeit: für alle .

Erfüllt eine Funktion die Eigenschaften 1 bis 3, so existiert ein Wahrscheinlichkeitsraum und eine Zufallsvariable auf diesem Wahrscheinlichkeitsraum dessen Verteilungsfunktion ist.