6 Momente von Zufallsvariablen

Bisher haben wir die “Zufälligkeit’’ einer Zufallsvariable

Insbesondere die folgenden zwei zentralen Fragen über eine Zufallsvariable

- Welchen Wert nimmt

- Wie sind die Werte von

Auf gewisse Weise haben wir uns diesen Fragen in Beispiel 4.5 über die

Definition 6.1 (Erwartungswert)

Für eine diskrete Zufallsvariable

Für eine absolutstetige Zufallsvariable

Bemerkung 6.1

Mit dem Erwartungswert kommen wir der ersten Frage zu Beginn dieses Kapitels deutlich näher. Aber er beantwortet die Frage nicht zu unseren vollständigen Zufriedenheit. Wir sagen umgangssprachlich, dass eine Zufallsvariable

Der Erwartungswert ist dennoch eine wichtige Kenngröße und fürs Erste geben wir uns mit dieser Näherung an Frage 1 zufrieden. Bzgl. der Interpretation des Erwartungswertes wird uns das sogenannte starke Gesetz der großen Zahlen in Kapitel 8 weitere Erkenntnisse liefern.Die Gleichung

Man spricht davon, dass

Allgemein und ohne die Unterscheidung zwischen stetigen und diskreten Zufallsvariablen definiert man den Erwartungswert

Beispiel 6.1

Für die Augenzahl

Für

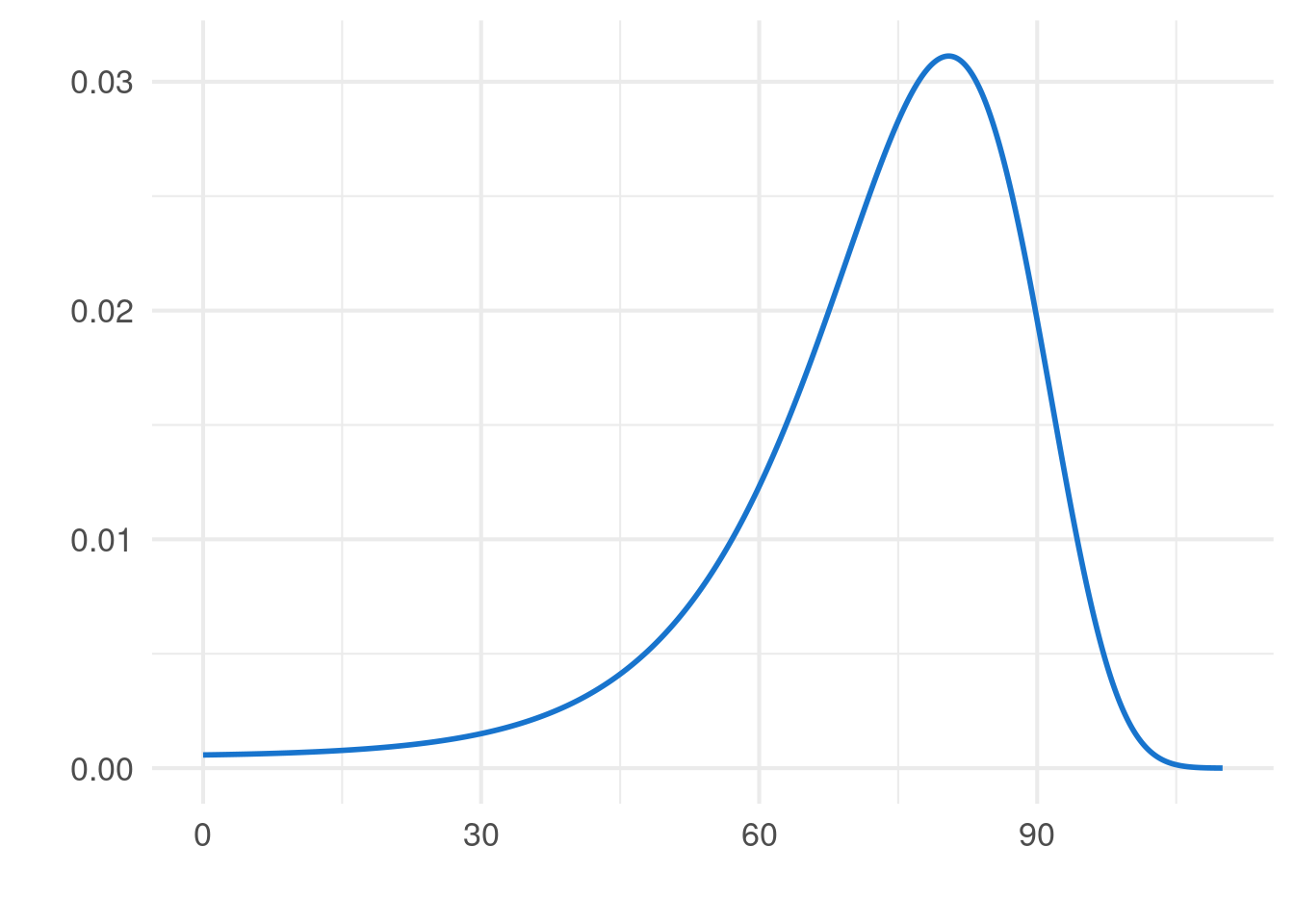

Wichtig: Der Erwartungswert ergibt sich nicht immer als das Maximum der Dichte. Hier wurde nur der Spezialfall der Normalverteilung besprochen.In Beispiel 4.6 haben wir festgestellt, dass die Exponentialverteilung keine sinnvolle Verteilung für die Lebensdauer

Häufig ist man nicht nur an dem Erwartungswert einer Zufallsvariable

Theorem 6.1 (“Law of the unconscious statistician’’ - LOTUS) Es sei

Bemerkung 6.2

Wir benötigen für die Berechnung von

Trotz der intuitiven Erklärung von Theorem 6.1 ist dies keine Definition, weswegen die Gleichung

Aus der Linearität des Integrals bzw. der Summe ergibt sich aus Theorem 6.1 die Linearität des Erwartungswertes, d.h. für alle

Falls

In Theorem 6.1 wurde vorausgesetzt, dass

Der Erwartungswert hilft uns, den “Mittelwert’’ einer Zufallsvariable zu bestimmen. Damit konnten wir die erste Frage zu Beginn des Kapitels

- Welchen Wert nimmt

hinreichend gut zu beantworten. Und wir können das gleiche Konzept auch auf die zweite Frage

- Wie sind die Werte von

anwenden. Dazu betrachten wir (zufällige) Abweichungen der Form

Definition 6.2 (Varianz, Standardabweichung) Für eine Zufallsvariable

Bemerkung 6.3

Die Varianz wird gerne verwendet, da sie große Abweichungen stärker “bestraft’’ als es die mittlere absolute Abweichung

Anhand der Definition erkennt man schnell, dass für alle

Da man mit der Varianz die Streuung einer Zufallsvariable untersucht, ist schnell klar, dass die Verschiebung aller Werte um

Die Streckung der Streuung um einen Faktor

Die Varianz lässt sich oft am einfachsten über die Verschiebungsformel

Oftmals bezeichnet man die Varianz auch als zweites zentriertes Moment. Allgemein definiert man das

Beispiel 6.2 Für eine Zufallsvariable