7 Zusammenhang von Zufallsvariablen

Bisher haben wir nur den Erwartungswert von eindimensionalen Zufallsvariablen untersucht. Wie wir in Kapitel 5 bereits besprochen haben, reicht es jedoch oft nicht aus, nur einzelne Zufallsvariablen zu betrachten. Daher bietet es sich an, die Konzepte von Kapitel 6 für Zufallsvektoren zu übertragen. Dies eröffnet uns auch die Möglichkeit, Zusammenhänge abseits der bisherigen binären Unterscheidung von abhängig und unabhängig zu beleuchten.

Zunächst stellen wir fest, dass der “Erwartungswert’’ eines Zufallvektors

Solange

Theorem 7.1 (LOTUS - Mehrdimensional) Es sei

Die Gleichung

Definition 7.1 (Kovarianz, Kovarianzmatrix) Es sei

Dann bezeichnen wir

Bemerkung 7.1

Offensichtlich gilt

Eine mögliche Motivation, warum es sinnvoll ist, die Varianz auf diese Weise (und nicht komponentenweise) zu verallgemeinern, wird über die Berechnung der Varianz von Linearkombinationen von

Man nennt

Abgesehen davon, dass die Kovarianzmatrix eine Verallgemeinerung der Varianz ist, sind die darin enthaltenen Kovarianzen ein fundamentales Abhängigkeitsmaß zwischen den Zufallsvariablen. Normiert man die Kovarianz mit dem Produkt der entsprechenden Standardabweichungen, so erhält man den Korrelationskoeffizienten.

Definition 7.2 (Korrelationskoeffizient) Es seien

Bemerkung 7.2

Wie bei den meisten Normierungen, bewirkt hier die Normierung, dass die Kovarianz in einen besser interpretierbaren Wertebereich transformiert wird. Es gilt

Sind

Falls

Aus

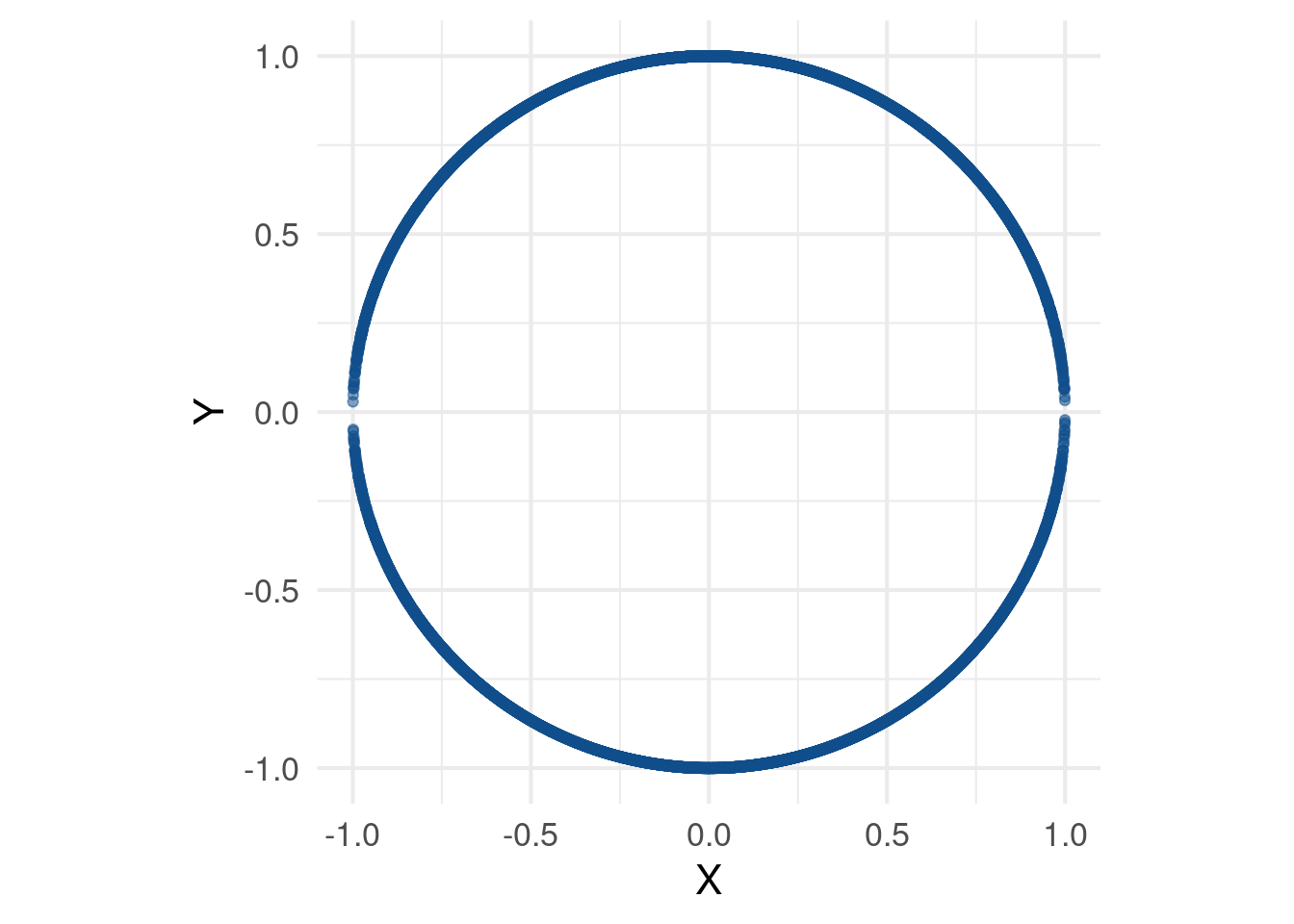

Beispiel 7.1 Es seien

Annahme 7.3 (Korrelation und Kausalität) Keine Stochastik- bzw. Statistikeinführung kann ohne die Aussage “Korrelation ist nicht Kausalität’’ auskommen. Grundgedanke hinter der Aussage ist die Tatsache, dass ein Nachweis von Korrelation zwischen zwei Größen

Insbesondere ist durch eine Korrelation nicht klar, ob

In diesem Fall ist es wohl eher nicht sinnvoll zu argumentieren, dass Eisgenuss plötzliche Mordlust weckt (

Weiterhin gibt es die Möglichkeit, dass eine Korrelation rein zufällig ist. Wenn man lang genug sucht, so findet man häufig irgendeine Korrelation, die nichts mit Kausalität zu tun hat. Eine Fundgrube an zufälligen Korrelationen findet sich auf tylervigen.com. Mein persönlicher Favorit findet sich in Abbildung 7.2 und beschreibt die Korrelation zwischen der Anzahl der in den USA verliehenen Doktortiteln im Bereich Mathematik und der Anzahl an Selbstmorden.

Klinische Studien versuchen diese Problematik “zu kontrollieren” und gelten in dieser Hinsicht als “Goldstandard”, da dort - vereinfacht gesagt - versucht wird, Studienteilnehmer in zwei möglichst ähnliche Menschengruppen zu unterteilen, wovon eine Gruppe das zu untersuchende Medikament und die andere Gruppe ein Placebo (Kontrollgruppe) erhält. Üblicherweise wissen weder die behandelnden Ärzte noch die Teilnehmer, wer in welcher Gruppe ist. Ein “signifikant besserer” Krankheitsverlauf innerhalb der Nicht-Placebogruppe wird dann der Wirkung des Medikaments zugeschrieben.

Der Zusammenhang zwischen Korrelation und Kausalität ist immer wieder ein kontroverses Thema. Neuerdings wird versucht, die Aussage “Korrelation ist nicht Kausalität’’ über sogenannte kausale Modelle zur Aussage”Manche Korrelationen sind Kausalität” zu entschärfen. In seinem populärwissenschaftlichen Buch (Pearl 2019) versucht der Informatiker und Philosoph Judea Pearl diese Sichtweise einem allgemeinen Publikum zu vermitteln und bietet dabei auch interessante Einblicke in die Historie der Statistik.