Aus den Analysisgrundvorlesungen kennt man üblicherweise das Konzept der punktweisen Konvergenz von Funktionsfolgen , wobei für alle eine reellwertige Funktion ist. Und wir schreiben punktweise, falls für alle gilt .

Wie mittlerweile bekannt sein sollte, sind Zufallsvariablen auch nichts anderes als (messbare) Funktionen. Somit könnte man das Konzept genauso gut für Folgen von Zufallsvariablen anwenden. Allerdings haben wir auch schon mehrfach festgestellt, dass uns die konkreten Stellen im Definitionsbereich von nur wenig interessieren. Wir haben auch festgestellt, dass für konkrete sogar sehr wilde Dinge tun kann, solange die entsprechenden eine Nullmenge bilden, d.h. für die Vereinigung aller Stellen an denen komische Dinge tut, gilt (siehe Bemerkung 3.1 und Beispiel 3.2). Dementsprechend ergibt es auch für Konvergenzbetrachtungen Sinn, diese Nullmengen zu ignorieren. Dies führ uns zur fast sicheren Konvergenz.

Definition 8.1 (Fast sichere Konvergenz) Es sei eine Folge von Zufallsvariablen . Wir sagen konvergiert fast sicher gegen eine Zufallsvariable , falls für . In diesem Fall schreiben wir .

Auf den ersten Blick mag Gleichung etwas abstrakt wirken. Letztendlich komprimiert diese Gleichung lediglich die Beschreibung zu Beginn dieses Kapitels. Dennoch fällt es zunächst schwer, die Wahrscheinlichkeit in Gleichung zu berechnen, um die Definitionsvoraussetzung zu überprüfen. Glücklicherweise gibt es ein praktisches Theorem, das uns hilft, fast sichere Konvergenz auf andere Weise nachzuweisen.

Theorem 8.1 Es seien beliebige Zufallsvariablen. Nun gilt für , falls für alle .

Bemerkung 8.1

Damit die Bedingung in Theorem 8.1 erfüllt sein kann, muss für alle gelten für . Dies bedeutet, dass die Wahrscheinlichkeit, dass und sich beliebig wenig unterscheiden, gegen Null geht.

Falls die Bedingung erfüllt ist, spricht man auch davon, dass in Wahrscheinlichkeit gegen konvergiert. Wir stellen also fest, dass wegen Bedingung gilt: Hinreichend schnelle Konvergenz in Wahrscheinlichkeit impliziert fast sichere Konvergenz (hinreichend schnell ist hierbei so zu verstehen, dass die Summe endlich ist).

Beispiel 8.1 Es sei U für alle . Wir stellen fest, dass , , usw. Dementsprechend ist mit steigendem auf einem immer kleiner werdenden Intervall gleichverteilt. Da für , lässt sich intuitiv überlegen, dass gegen die (langweilige konstante) Zufallsvariable konvergiert.

Nach Bemerkung 8.1 könnte diese Konvergenz im Sinne der Konvergenz in Wahrscheinlichkeit verlaufen und wenn dies hinreichend schnell passiert, dann können wir sogar fast sichere Konvergenz über Theorem 8.1 folgern. Rechnen wir also zunächst Bedingung nach. Dazu sei und es gilt

für . Also wissen wir, dass in Wahrscheinlichkeit gegen konvergiert. Außerdem ist wegen der Indikatorfunktion die Summe in Bedingung als Summe von endlich vielen Termen auch endlich ist. Damit gilt .

In Kapitel 6 haben wir den Erwartungswert einer Zufallsvariable kennengelernt und diesen als den Wert interpretiert, der “im Mittel’’ angenommen wird. Allerdings hat bereits Beispiel 6.1 gezeigt, dass diese Interpretation ein wenig hinkt. Schließlich haben wir dort festgestellt, dass wir für eine gewürfelten Zahl einen Erwartungswert von erhalten. Allerdings ist es unmöglich eine zu würfeln (jedenfalls mit einem Standardwürfel).

Nachdem wir nun das Konzept von fast sicherer Konvergenz kennen, können wir unser Verständnis des Erwartungswertes aufpolieren.

Theorem 8.2 (Starkes Gesetz der großen Zahlen) Es seien , , unabhängige und identisch verteilte Zufallsvariablen. Dann existiert ein endlicher Erwartungswert genau dann, wenn für .

Bemerkung 8.2

Somit kann man den Erwartungswert einer Zufallsvariable als arithmetisches Mittel von unendlich vielen, unabhängigen Kopien von betrachten.

Die Bezeichnung “starkes’’ Gesetz bezieht sich im Wesentlichen darauf, dass die Konvergenz als fast sichere Konvergenz zu verstehen ist. Das schwache Gesetz der großen Zahlen versteht diese Konvergenz allerdings nur als Konvergenz in Wahrscheinlichkeit.

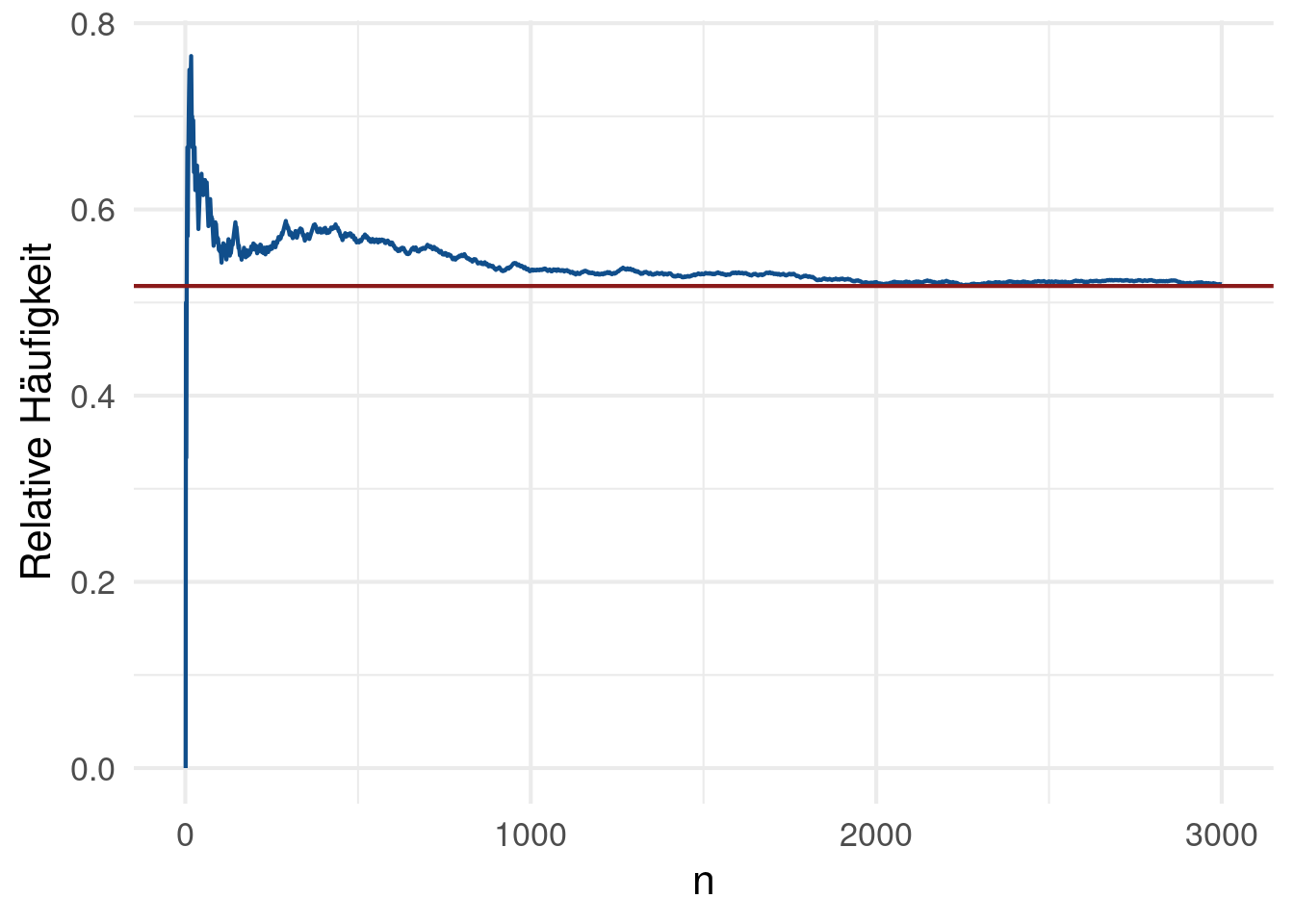

Beispiel 8.2 Mithilfe des SGGZ und der Überlegung für ein Ereignis erhält man leicht, dass für unabhängige Kopien , , der Zufallsvariable gilt wobei angibt, wie oft das Ereignis eingetreten ist. Somit gibt das starke Gesetz der großen Zahlen auch eine Begründung, warum man die relative Häufigkeit als Wahrscheinlichkeit interpretiert.

Konkreter können wir das folgende Würfelspiel betrachten. Ein Würfel wird maximal mal geworfen und wir gewinnen das Spiel, wenn wir eine würfeln. Wir definieren nun , , wobei . Somit gilt Ber mit und wir nehmen an, dass die unabhängig voneinander sind. Nach dem SGGZ wissen wir nun, dass die relative Häufigkeit der Gewinne nach Spielen für gegen konvergiert (siehe Abbildung 8.1).

In den vorangegangenen Kapitel haben wir die Verteilungsfunktion einer Zufallsvariable als wertvolle Charakteristik eingeführt. Außerdem haben wir zu Beginn dieses Kapitels die fast sichere Konvergenz als abgeschwächte Version der punktweisen Konvergenz von Funktionenfolgen kennengelernt. Somit stellt sich die Frage, ob wir die Konvergenz von Zufallsvariablen auch über die punktweise Konvergenz von Funktionenfolgen, bestehend aus den zugehörigen Verteilungsfunktionen , beschreiben können. Tatsächlich ist dies möglich, führt aber (wiedermal) zu einem neuen Konvergenzbegriff.

Definition 8.2 (Konvergenz in Verteilung) Es seien und , Zufallsvariablen mit zugehörigen Verteilungsfunktionen und . Wir sagen, dass für in Verteilung gegen konvergiert, falls für und schreiben .

Bemerkung 8.3

Streng genommen ist dies eine Konvergenz von Verteilungen und keine Konvergenz von Zufallsvariablen. Allerdings nimmt man diese leichte Durchmischung von Begrifflichkeiten in Kauf, da Verteilungsfunktionen und Zufallsvariablen, wie wir wissen, sehr eng in Verbindung stehen.

Intuitiv lässt sich vermuten, dass, wenn Zufallsvariablen fast sicher oder in Wahrscheinlichkeit gegen konvergieren, auch die Verteilungsfunktionen der gegen die Verteilungsfunktion von konvergieren. Tatsächlich lässt sich dies auch beweisen. Die Umkehrung gilt allerdings nicht.

Insgesamt haben wir also

Die Konvergenz in Verteilung lässt sich sehr gut visualisieren. Dies haben wir bereits in Beispiel 4.5 bzw. Abbildung 4.3 mithilfe von Histogrammen (als “grafische Approximation’’ einer Verteilung) demonstriert. In dieser Abbildung haben wir gesehen, wie die mit geeigneten Koeffizienten und zentrierte und normierte Summe von unabhängigen und identisch verteilten Zufallsvariablen gegen die Standardnormalverteilung konvergiert. In Zeichen haben wir gezeigt, dass wobei eine standardnormalverteilte Zufallsvariable ist. Die konkrete Zentrierung und Normierung ist in Beispiel 4.5 mehr oder weniger vom Himmel gefallen. Nun haben wir sämtliches Handwerkszeug zur Verfügung, um die Koeffizienten beleuchten zu können. Diese ergeben sich aus einem der fundamentalsten Theoreme der Stochastik.

Theorem 8.3 (Zentraler Grenzwertsatz - ZGWS) Es seien , unabhängige und identisch verteilte Zufallsvariablen mit und . Dann gilt für alle für , wobei die Verteilungsfunktion einer standardnormalverteilten Zufallsvariable ist.

Bemerkung 8.4

Die geeigneten Koeffizienten sind also gegeben durch und .

Betrachten wir unabhängige und identisch verteile Zufallsvariablen , , mit und , so besagt der ZGWS, dass mit gilt Allerdings lässt sich zeigen, dass mit Wahrscheinlichkeit 1

(Zur Erinnerung sei hierbei erwähnt, dass der Limes superior bzw. Limes inferior einer Folge von reellen Zahlen der größte bzw. kleinste Häufungspunkt ist. Im Falle von Funktionenfolgen ist dies punktweise zu verstehen.)

Somit kann man die Konvergenz nicht alternativ als fast sichere Konvergenz auffassen, da . Allerdings wissen wir durch das SGGZ, dass für . Somit erkennt man, dass die Normierung einen entscheidenden Einfluss auf die Konvergenz(art) hat.

Dazu hat sich die Bezeichnung “Gesetze der großen Zahlen” für Grenzwertsätze mit Normierung und “Zentrale Grenzwertsätze” für Grenzwertsätze mit Normierung eingebürgert.

Eine Form, die zwischen diesen beiden Normierungen liegt, beschreiben die “Gesetze des iterierten Logarithmus’’. Diese nutzen eine Normierung der Form und beschreiben das asymptotische Verhalten von .